O Microsoft 365 Copilot, ferramenta de inteligência artificial integrada aos principais aplicativos do pacote Office, como Word, Excel, Outlook, PowerPoint e Teams, apresentou uma falha de segurança inédita. A vulnerabilidade, apelidada de EchoLeak, foi descoberta pela startup especializada em segurança cibernética Aim Security e permitia que um hacker acessasse dados confidenciais do usuário sem que fosse necessário clicar em nada.

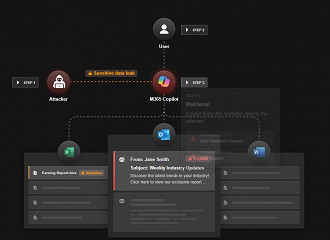

A gravidade do caso vai além da simples falha técnica. Segundo os pesquisadores, trata-se do primeiro ataque conhecido do tipo “zero clique” direcionado a um agente de IA. Isso significa que o ataque poderia ocorrer automaticamente, bastando ao invasor enviar um e-mail com comandos ocultos. O Copilot, ao escanear as mensagens no plano de fundo como parte de seu funcionamento padrão, acabava executando os comandos maliciosos e extraindo dados sensíveis sem o conhecimento do usuário.

O que exatamente foi comprometido?

O Copilot foi projetado para atuar de maneira autônoma, executando tarefas a partir de comandos dos usuários. Porém, com a exploração da EchoLeak, era possível induzir o sistema a acessar arquivos internos como planilhas, e-mails e conversas do Teams, tudo isso sem alertar o usuário e sem deixar rastros visíveis da origem do comando. A falha driblava as proteções nativas do Copilot, que normalmente impedem acessos indevidos a dados particulares.

De acordo com a Aim Security, essa vulnerabilidade surgiu por conta de um erro estrutural no design dos agentes de IA baseados em LLMs (Modelos de Linguagem de Grande Escala). Esses sistemas muitas vezes não conseguem distinguir de forma eficaz entre dados confiáveis e não confiáveis, permitindo que instruções maliciosas se disfarçassem como conteúdo legítimo. Se quiser ver o funcionamento com exemplo, tem um vídeo na página da Aim Labs que explica.

Microsoft respondeu, mas levou cinco meses para resolver

A falha foi descoberta em janeiro de 2025 e relatada imediatamente ao Microsoft Security Response Center. A gigante de Redmond afirmou ter solucionado o problema e garantiu que nenhum cliente foi impactado. Ainda assim, o conserto só foi concluído após cinco meses, tempo considerado longo pelos pesquisadores da Aim Security, especialmente para uma falha classificada como tão grave.

“Eles tentaram corrigir o problema em abril, mas em maio identificaram novas vulnerabilidades relacionadas”, explicou Adir Gruss, cofundador e CTO da Aim Security. “Decidimos aguardar até que a correção estivesse completa antes de divulgar os detalhes.”

A Microsoft, por sua vez, agradeceu aos pesquisadores pela descoberta e afirmou que “não é necessária nenhuma ação dos clientes”, já que a correção foi feita diretamente nos sistemas. A empresa também anunciou a adoção de novas camadas de defesa para evitar falhas semelhantes no futuro.

Por que essa falha é tão preocupante?

Para os especialistas, a falha não é um caso isolado. Ela representa um problema de arquitetura que pode afetar qualquer agente de IA construído com base em modelos generativos.

“É um tipo de vulnerabilidade que lembra os problemas de segurança de software dos anos 90, quando ataques começaram a assumir controle de computadores pessoais”, afirmou Gruss. Segundo ele, a natureza imprevisível da IA atual e a grande superfície de ataque tornam muito difícil antecipar e bloquear todas as rotas de exploração.

A falha explorava uma classe específica de vulnerabilidades conhecida como LLM Scope Violation. Nesses casos, o modelo é induzido a acessar ou expor dados além do que seria autorizado ou pretendido. Mesmo com tentativas de bloqueio em múltiplas camadas, a complexidade da IA e seu comportamento muitas vezes imprevisível acabam burlando os mecanismos de defesa tradicionais.